4. 투명성

1. 컴컴한 상자 속 같은 인공지능 기술

인공지능 기술은 다양한 문제에서 사람이 해결하는 것과 비슷하거나 그보다 더욱 뛰어난 성능을 보여주고 있습니다. 이렇듯 인공지능은 고도의 지능을 갖추고 있지만, 이 지능을 외부에서 쉽게 판단하기 힘든 경우가 많습니다. 인공지능 기술(머신러닝 등)은 빅데이터 및 복잡한 알고리즘 등을 기반으로 사용자에게 의사결정, 추천, 예측 등의 정보를 제공하지만, 대부분 내부에서 일어나는 의사 결정 과정이 불투명하기 때문입니다. 인공지능의 결정 과정에 대한 설명이 부족하면, 인공지능을 통해 생성된 결과 또는 예측에 대하여 분석을 할 수 없으며, 그에 따라 인공지능을 완전히 신뢰하고 사용할 수 없습니다. 예를 들어 금융, 보험, 의료 등의 분야는 고객의 신뢰를 기반으로 개인 정보와 자산 등을 다루기 때문에 생성된 결과의 도출 근거와 도출 과정의 타당성 등이 확인되지 않는다면 문제가 발생할 것입니다. 지금부터 인공지능의 투명성과 관련된 사례를 살펴봅시다.

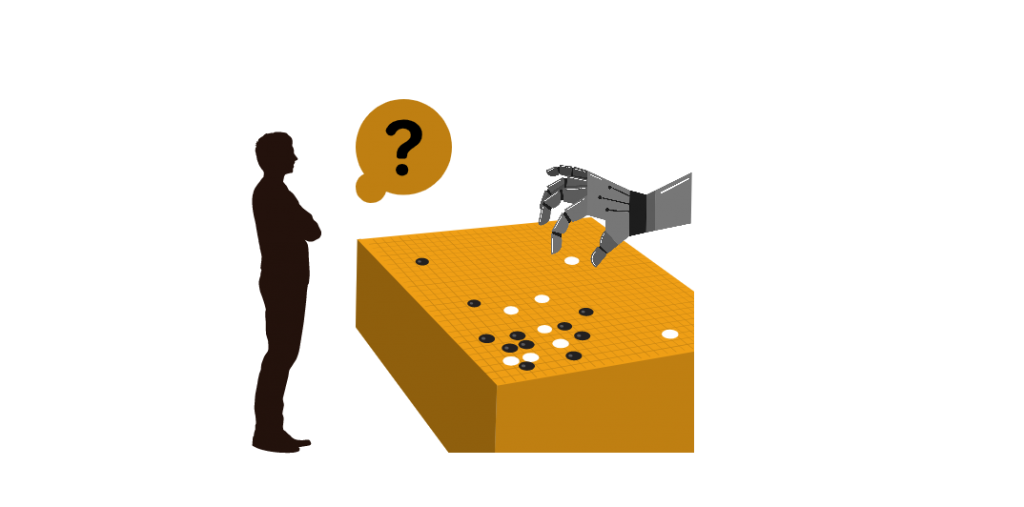

2. 알파고는 이세돌을 어떻게 이겼을까?

3. 기대한 반응과 다른 행동을 하는 자동차, 안전할까?

2016년, 엔비디아는 엔지니어나 프로그래머가 내린 명령이 아닌 인공지능 스스로 운전 방법을 학습하도록 만든 자율주행 자동차를 내놓았습니다. 그런데 이 자율주행 자동차는 자동차가 어떻게 판단을 내리고 선택하는지 알 수가 없다는 문제점이 있었습니다. 만약 자동차가 기대한 반응과 다르게 이상한 행동을 한다면 어떻게 될까요? 이유를 모르는 상태에서 이 자동차를 사용할 수 있을까요?

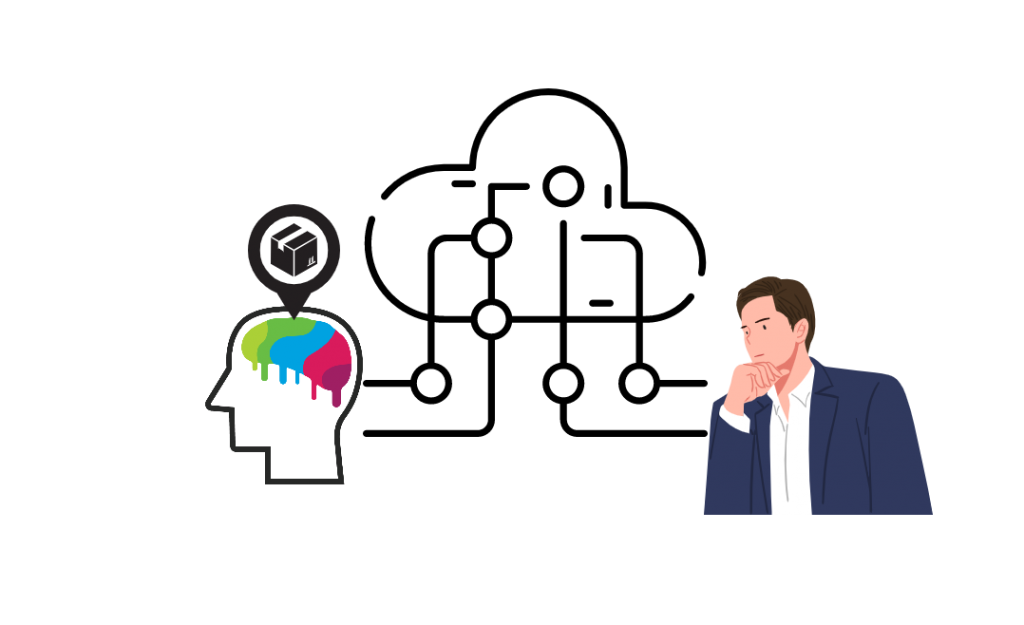

4. 투명성의 문제는 어떻게 해결해나갈까?

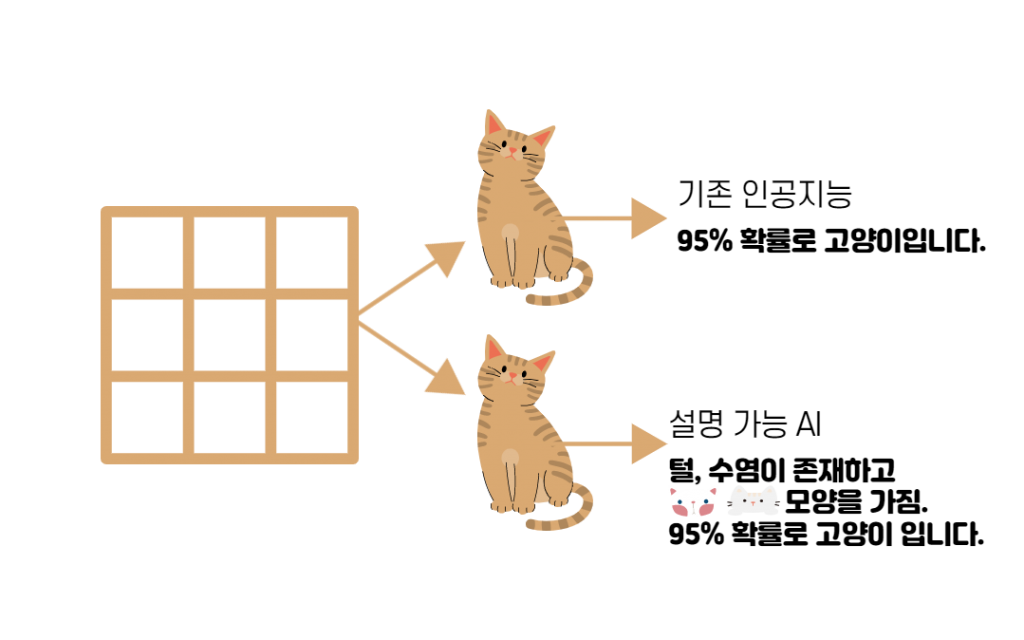

인공지능 개발자는 설명 가능하고 해석 가능한 인공지능 기술을 제공해야 합니다. 설명 가능한 인공지능은 아래에서 조금 더 살펴봅시다. 또, 은닉 기능을 개발하지 않으며 위험에 대한 적극적 예측에 노력을 기울여야 합니다.

인공지능 공급자는 위험 관련 정보를 이용자와 공유하며, 이용자 대상 제품 교육과 매뉴얼을 제공해야 합니다. 또, 사회적 영향 평가 결과를 기술 개발 및 서비스 설계에 반영해야 합니다.

인공지능 이용자는 특정 서비스 과정에 대한 설명을 개발자나 공급자에게 요구할 권리가 있고 공개적이고 투명성이 확보된 기술을 사용해야 합니다. 또, 인공지능 기술 이용에 따른 이상 현상과 부작용 등에 관하여 습득한 경험을 공유해야 합니다.

5. 윤리적 인공지능 - 투명성 OX 퀴즈

인공지능 기술(머신러닝 등)은 대부분 내부에서 일어나는 의사 결정 과정이 불투명하다.

인공지능 기술(머신러닝 등)은 대부분 내부에서 일어나는 의사 결정 과정이 불투명하다.

구글 딥마인드는 알파고가 이세돌 9단을 어떻게 이겼는지 복기 과정을 통해 알아내었다.

알파고가 이세돌 9단을 어떻게 이겼는지에 대한 정확한 과정을 아무도 알아낼 수 없었습니다.

인공지능 개발자는 설명 가능하고 해석 가능한 인공지능 기술을 제공해야 한다.

인공지능 개발자는 설명 가능하고 해석 가능한 인공지능 기술을 제공해야 한다.

<출처>

미래신호 탐지 기법으로 본 인공지능 윤리 이슈 – 글로벌 동향과 전망(2017, 한국정보화진흥원)

인공지능 윤리의 필요성과 국내외 동향(2017, 한국통신학회)

설명가능 인공지능(XAI)(2016, 미 국방연구원)

설명 가능한 인공지능(eXplainable AI, XAI) 소개(2018, 금융보안원)

설명 가능한 인공지능 기술의 소개(2019, 전자공학회지)