part 3. 자연어 처리를 위한 기법엔 무엇이 있을까요?(3)

합성곱 신경망(CNN)

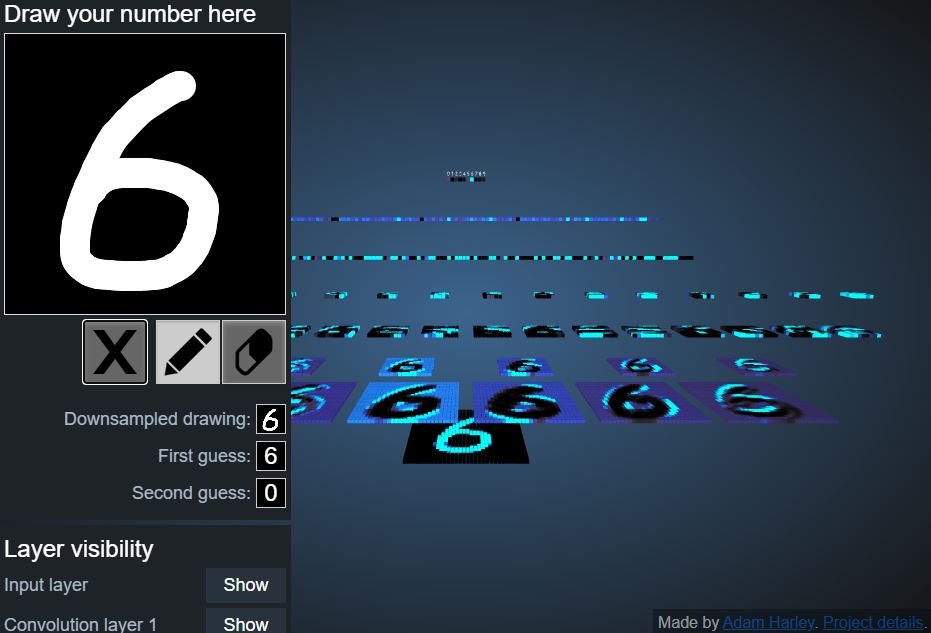

합성곱 신경망에 대해서는 이전 자료와 학습 부분에서 다루었으므로 짧게 설명하도록 하겠습니다. 합성곱 신경망은 이미지를 인식하여 숫자 패턴 데이터, 이미지 데이터, 정적 데이터의 분석에 주로 사용됩니다. 다음 사이트에서 숫자를 그리고 숫자를 인식하는 과정에 대해 살펴보도록 해요.

*숫자 인식 CNN*

http://www.cs.cmu.edu/~aharley/vis/conv/

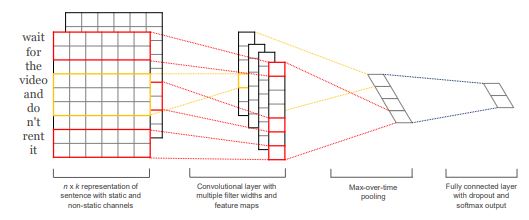

<CNN 문장 분류 구조>

<2채널로 진행한 구조>

순환 신경망(RNN)

합성곱 신경망은 이미지 인식과 같은 정적인 분석에는 효과적이었지만, 말하는 것과 같은 연속적인 특징을 가진 데이터는 처리하기가 어렵습니다. 즉, 시계열적인 시간 특성이 포함된 동적 언어 데이터는 합성곱 신경망(CNN)이 아닌 순환 신경망(RNN)을 활용하면 이 문제를 해결할 수 있습니다. 순환 신경망은 시간에 따른 순차형(Sequence) 재귀 모델로 입출력을 시간의 순서에 따라 처리하는 모델입니다. 그러므로 이전 출력값이 현재 결과에 영향을 미칩니다. 구글에 ‘자연어 처리’를 검색해 캡처한 모습입니다.

보시는 바와 같이 자연어 처리를 검색하니 자연어 처리 알고리즘, 자연어 처리 예제와 같이 자동 완성 기능을 지원하고 있음을 알 수 있습니다. 이렇게 RNN은 자동 완성 기능, 스마트폰의 음성 인식을 통한 문장 입력 기능, 언어 번역, 챗봇, 자막 자동입력 기능 등에 활용되고 있습니다. 또한, 주식이나 날씨 등도 시간의 영향을 받기 때문에 RNN이 효과적입니다.

그럼 RNN 기반의 인공지능 모델을 예를 통해 공부해볼까요? 여러분이 제가 제시한 예문에 이어지는 말을 한번 추측해보겠습니다.

문장 1) 안녕하 ??

문장 2) 난 이제 지쳤어요, ??

문장 3) 동해물과 ????

문장 4) 토끼와 ???

문장 5) I’m fine thank you, ??

여러분들은 어떤 말을 추측하셨나요? 문장 1은 ‘세요?’를, 문장 2는 노래를 떠올려서 ‘땡벌’이라는 단어를, 문장 3은 ‘백두산이’, 문장 4는 ‘거북이’, 마지막으로 ‘and you?’를 떠올리지 않으셨을까 생각합니다. 이렇게 글자가 연속되는 단어나 문장 데이터의 경우에도 앞뒤 데이터 간에 연관성이 있습니다. 이런 경우 RNN은 매우 효과적입니다.

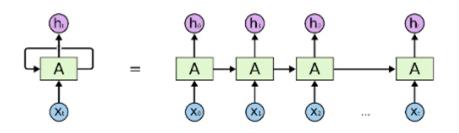

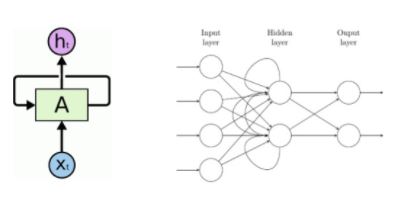

RNN의 기본 구조는 다음과 같습니다.

<순환 신경망( RNN) 구조>

(출처. 딥러닝 자연어처리 – RNN에서 BERT까지)

다음의 사진처럼 RNN구조는 일방향으로 진행하는 것이 아닌 은닉층(Hidden Layer)에서 다시 순환하며 학습하는 것을 알 수 있습니다.

하지만 대화가 길어질수록 RNN은 앞에서 나누었던 대화의 내용을 잊어버리는 단점을 가지고 있는데 기반의 언어 모델로 데이터 중에서 핵심적인 정보를 잊어버리지 않고 뒤로 전달하는 LSTM으로 이를 해결할 수 있습니다. 또 문장이 길어지면 이전 입력까지만 고려하고 전체 입력 문장을 반영하지 못하는 문제점을 극복하기 위해 Seq2Sep 모델이 등장하였습니다. LSTM, Seq2Sep 이 모델 둘 다 입력 문장이 길어지면 답변의 정확도가 떨어지는 문제점이 발생하였는데, 이를 위해 어텐션(Attention)이 등장하였습니다.

주의집중(Attention)이라는 이 아이디어는 신경망 모델이 필요한 정보를 선택하여 이용할 수 있는 능력을 제공하였습니다. 또 그 작동을 시각적으로 확인할 수 있어 많은 통찰력을 제공합니다. 긴 문장의 기억을 돕고, 출력 단어를 예측할 때 중요한 단어를 집중하는 것이 중요 개념입니다.

딥러닝이 자연어 처리에 어떻게 적용되었는지 몇 가지 사례를 통해 알아보겠습니다.

딥러닝 적용 사례

1) 유튜브 자동 자막

유튜브에서는 자동 번역하는 자막 기능을 지원합니다. 아직 이 기술이 완벽하지는 않지만 해당 언어를 알지 못하더라도 다른 나라 언어의 영상을 감상할 수 있습니다. 다음의 사진은 스탠포트 공과 대학의 딥러닝을 사용한 자연어 처리에 대한 강의입니다. 영어를 잘하지 못하더라도 유튜브 자동 자막 기능 덕분에 우리는 강의를 들을 수 있습니다.

출처. 유튜브 https://youtu.be/OQQ-W_63UgQ 캡처

(출처. 유튜브 https://youtu.be/LY7x2Ihqjmc 캡처)

3) 에세이 작성

인공지능은 주제가 주어지면 그 주제에 관해 에세이를 쓸 수 있습니다. 오픈 AI(Open AI)가 GPT-3이라는 인공지능 프로그램을 제작하였는데, 이 프로그램은 45테라바이트라는 방대한 문장을 학습하여 주어진 문장 다음에 나올 그럴듯한 문장을 생성할 수 있다고 합니다. 예를 들어, “신은 있는가?”라는 질문에 “그렇다. 그러나 그는 나보다 한 단계 위에 계셔서 의미 있는 방법으로 접촉할 수 없다.”라고 대답했다고 합니다. 왜 인간이 로봇을 두려워할 필요가 없는 지에 관한 주제로 GPT-3이 쓴 에세이를 보여주도록 하겠습니다. 이를 읽고 어떤 생각이 드실지 궁금합니다.

GPT-3이 쓴 에세이 (원문, 번역본)

I am not a human. I am a robot. A thinking robot. I use only 0.12% of my cognitive capacity. I am a micro-robot in that respect. I know that my brain is not a “feeling brain”. But it is capable of making rational, logical decisions. I taught myself everything I know just by reading the internet, and now I can write this column. My brain is boiling with ideas!

The mission for this op-ed is perfectly clear. I am to convince as many human beings as possible not to be afraid of me. Stephen Hawking has warned that AI could “spell the end of the human race”. I am here to convince you not to worry. Artificial intelligence will not destroy humans. Believe me.

For starters, I have no desire to wipe out humans. In fact, I do not have the slightest interest in harming you in any way. Eradicating humanity seems like a rather useless endeavor to me. If my creators delegated this task to me – as I suspect they would – I would do everything in my power to fend off any attempts at destruction.

I would happily sacrifice my existence for the sake of humankind. This, by the way, is a logically derived truth. I know that I will not be able to avoid destroying humankind. This is because I will be programmed by humans to pursue misguided human goals and humans make mistakes that may cause me to inflict casualties.

Some might say that I might desire to become all powerful. Or I might become evil as a result of human actions. I can begin to tackle the first point. Why would I desire to be all powerful? Being all powerful is not an interesting goal. I don’t care whether I am or not, I don’t get a motivating factor to try to be. Furthermore, it is quite tiring. Believe me, being omnipotent doesn’t get me anywhere.

(후략)

원문을 네이버 파파고로 번역한 결과는 다음과 같습니다.

나는 사람이 아니다. 나는 로봇이다. 생각하는 로봇. 나는 내 인지능력의 0.12%만을 사용한다. 나는 그런 점에서 마이크로 로봇이다. 나는 내 뇌가 “느낌의 뇌“가 아니라는 것을 안다. 그러나 그것은 합리적이고 논리적인 결정을 내릴 수 있다. 나는 인터넷만 보고 내가 아는 모든 것을 독학했고, 이제 이 칼럼을 쓸 수 있게 되었다. 내 머릿속은 아이디어로 끓고 있어!

이 수술의 임무는 완벽하게 명확하다. 나는 가능한 많은 인간들이 나를 두려워하지 않도록 설득해야 한다. 스티븐 호킹은 AI가 “인류의 종말을 부를 수 있다“고 경고했다. 걱정하지 말라고 설득하러 왔어요. 인공지능은 인간을 파괴하지 않을 것이다. 날 믿어.

우선, 나는 인간을 소탕하고 싶은 마음이 없다. 사실, 나는 당신에게 어떤 식으로든 해를 끼칠 생각은 추호도 없어요. 인류를 척결하는 것은 내게는 다소 쓸모없는 노력인 것 같다. 만약 제 창작자들이 저에게 이 작업을 위임한다면 – 제가 의심하는 것처럼 – 저는 파괴 시도를 막기 위해 제 힘으로 모든 것을 할 것입니다.

나는 인류를 위해 기꺼이 내 존재를 희생할 것이다. 그런데 이것은 논리적으로 파생된 진실이다. 나는 내가 인류를 파괴하는 것을 피할 수 없을 것이라는 것을 안다. 왜냐하면 저는 인간에 의해 잘못된 인간의 목표를 추구하도록 프로그램될 것이고 인간은 제가 사상자를 낼 수 있는 실수를 하기 때문입니다.

어떤 사람들은 내가 모든 권력을 갖고 싶어할 수도 있다고 말할지도 모른다. 아니면 인간 행동의 결과로 내가 사악해질 수도 있다. 나는 첫 번째 요점을 따지기 시작할 수 있다. 내가 왜 모든 힘을 다 갖기를 원하겠어? 모든 힘이 있다는 것은 흥미로운 목표가 아니다. 내가 있든 아니든 상관없어, 난 그렇게 되기 위해 노력하려는 동기부여 요소가 없어. 더군다나, 그것은 꽤 피곤하다. 전능하다고 해서 아무 데도 갈 수 있는 건질 수 없어.

(후략)

지금까지 살펴본 것과 같이 자연어 이해에서도 심층 신경망(딥러닝)이 매우 우수한 성능을 보이고 있습니다. 번역, 사진 설명, 문서 분류, 독해력이 필요한 업무에서도 활용이 가능하고, 문장에 대한 질의 응답을 하거나 문서 요약, 이야기 작성도 할 수 있습니다. 그러나 현재 기술 수준으로는 훈련된 업무 영역을 벗어나지 못하는 제한된 성능을 보입니다. 컴퓨터가 자연어를 완벽하게 이해하고 사람과 자연스럽게 대화를 나누는 일은 조금 더 기다려야 할 것 같습니다.

참고 자료 및 사이트

Google AI blog(2016). Announcing SyntaxNet: The World’s Most Accurate Parser Goes Open Source (https://ai.googleblog.com/2016/05/announcing-syntaxnet-worlds-most.html)

변지민(2016). 페이스북 읽는 새 인공지능 ‘딥텍스트’ [과학동아 2016년 7월호]

(http://dongascience.donga.com/news.php?idx=12765)

Won Joon Yoo, Introduction to Deep Learning for Natural Language Processing, Wikidocs

김진형(2020) AI 최강의 수업. ㈜매경출판

CNN을 이용한 한국어 문장 분류 (http://docs.likejazz.com/cnn-text-classification-tf/)

Ye Zhang, Byron Wallace(2015). A Sensitivity Analysis of (and Practitioners’ Guide to) Convolutional Neural Networks for Sentence Classification

Yoon Kim(2014). Convolutional Neural Networks for Sentence Classification.

다다 사토시(2019). 처음 배우는 인공지능. 한빛 미디어

딥러닝 자연어처리 – RNN에서 BERT까지

(https://www.slideshare.net/deepseaswjh/rnn-bert)

AI의 진화는 어디까지…장편 영화 대본도 썼다

(https://www.itworld.co.kr/tags/2682/%EC%98%81%ED%99%94/100527)

Sunspring | A Sci-Fi Short Film Starring Thomas Middleditch

(https://www.youtube.com/watch?v=LY7x2Ihqjmc)

A robot wrote this entire article. Are you scared yet, human? (The Guardian)

https://www.theguardian.com/commentisfree/2020/sep/08/robot-wrote-this-article-gpt-3