안전한 AI는 인간이 사용하기에 인공지능이 얼마나 안전한지, 믿고 사용해도 되는가에 관한 것입니다. 앞에서 살펴보았듯이 인공지능의 알고리즘이 불완전할 경우 다양한 윤리적 문제를 일으킵니다. 더욱이 인공지능 기술은 자율성을 가지고 있기 때문에 인간이 인공지능 기술을 안전하게 관리하고 적절하게 제어하지 못한다면 기술이 사람들에게 위협이 될 수도 있습니다. 더 나아가 안전성이 떨어지는 인공지능 기술을 사용했다가 인명 피해가 발생한다면 더 큰 문제가 될 것입니다. 지금부터 인공지능의 안전성으로 발생하는 문제 사례를 살펴봅시다.

2015년 구글이 제공하는 포토 서비스에서 흑인 여자를 고릴라로 인식한 사건이 발생하였습니다. 뉴욕에서 일하는 흑인 프로그래머 재키 앨신은, 자신의 여자친구가 고릴라로 자동 분류된 사진을 보고 깜짝 놀랐습니다. 그리고 이 사실을 트위터에 공개적으로 비판했고 게시물이 올라온지 약 1시간 30분 뒤 구글에서 공개적으로 사과한 후 긴급 패치로 문제를 해결했습니다. 인간을 동물로 인식하여 도덕적 물의를 일으킨 인공지능을 과연 안전하다고 믿고 사용할 수 있을까요?

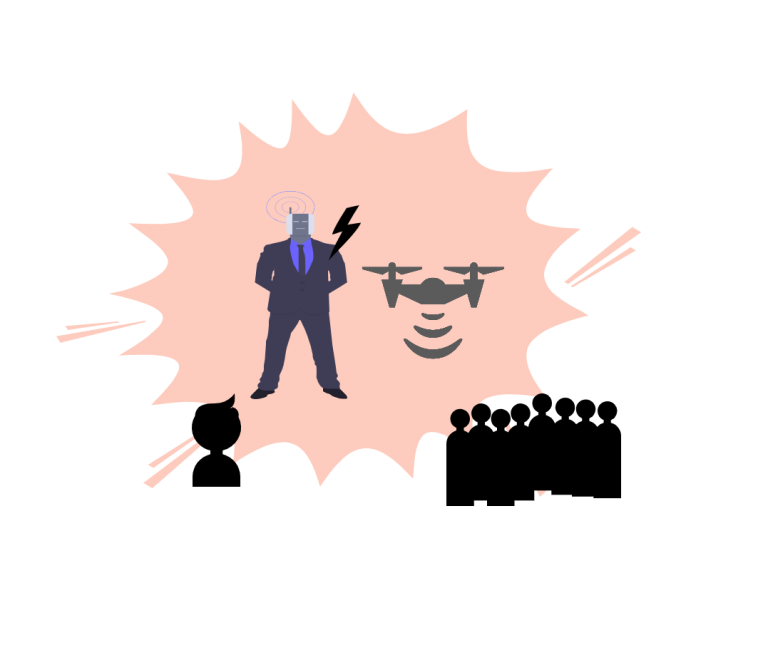

인공지능 기술은 자율성을 가지고 있기 때문에 인간이 인공지능 기술을 안전하게 관리하고 적절하게 제어하지 못한다면 기술이 사람들에게 위협이 될 수도 있다.

구글 포토 서비스에서 인간을 동물로 인식하여 도덕적 물의를 일으킨 사례가 있다.

인공지능 개발자는 오작동 및 위험에 대한 제어 장치를 마련해야 합니다.

<출처>

미래신호 탐지 기법으로 본 인공지능 윤리 이슈 – 글로벌 동향과 전망(2017, 한국정보화진흥원)

인공지능 윤리의 필요성과 국내외 동향(2017, 한국통신학회)

인천인공지능교육 표준안 및 가이드라인 연구(2020, 인천광역시교육청, 한국인공지능교육학회)

© 2025 AI4School. Built using WordPress and the Mesmerize Theme