2. 책임성

1. 인공지능과 로봇에게도 우리처럼 책임이 있을까?

책임성은 인공지능과 로봇이 내린 판단과 행동에 대해 누가 어떻게 책임을 질 것인가에 관한 것입니다. 즉 책임의 주체를 결정하는 문제입니다. 인공지능과 로봇이 인간처럼 의사결정을 하는 것에 대한 우려의 소리가 높아지고 있습니다. 인간은 자신이 행한 일에 대한 법적 지위와 책임이 있는데, 인공지능과 로봇도 인간처럼 그들이 결정한 것에 책임을 질 수 있는지 고민해보아야 할 시점이 된 것입니다. 인공지능의 책임성과 관련된 사례를 살펴봅시다.

2. 인공지능 의사의 진료와 처방에도 책임이 있을까?

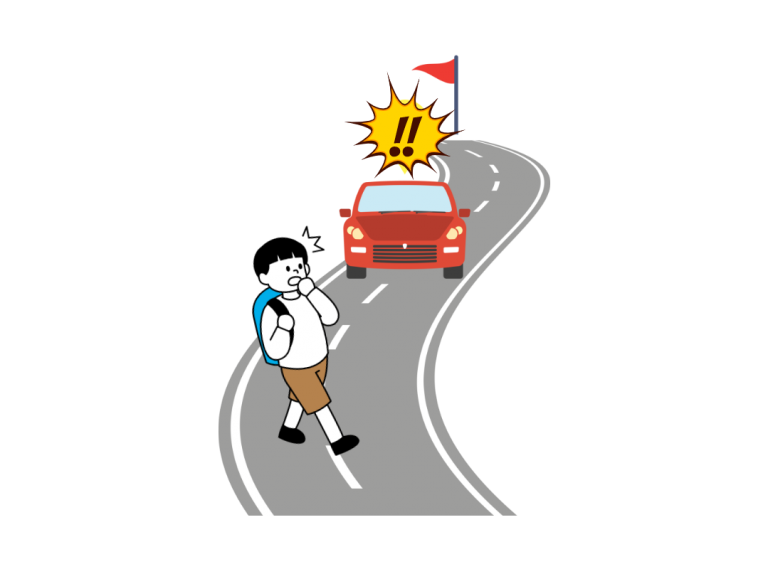

3. 자율주행차가 누구를 살리는 것이 맞는 선택일까?

최근 인공지능 기술의 발전으로 자율주행 자동차의 상용화가 일어나기 시작했습니다. 자율주행 자동차의 시장 규모는 나날이 커져 2035년에는 약 1조 1,204억 달러에 이를 것이라는 전망도 있습니다. 이러한 자율주행 자동차 역시도 윤리적인 이슈를 피해갈 수는 없습니다. 자율 주행자동차로 인명 피해 사고가 날 경우, 윤리적인 판단을 한 자율주행 자동차에게도 책임이 있는가 하는 문제입니다. 이러한 문제는 자율주행 자동차를 만들고 사용하는 데 반드시 고민해보아야 할 문제입니다.

자, 지금부터 여러분이 자율주행 자동차를 설계하는 사람이라고 상상해봅시다. 브레이크가 작동하지 않는 상태에서 자율주행 자동차가 어느 방향으로 돌진해야 하는지 기준을 세우고 싶습니다. 자율주행 자동차의 운전자와 보행자 중 한 사람만 살 수 있다면 누구를 살려야 할까요? 내 앞에 두 명의 보행자가 있는데 둘 중에 한쪽으로 돌진해야 한다면 어떠한 기준으로 선택해야 할까요? 모든 사람의 생명은 모두 소중한데 선택의 기준을 만들려고 하니 참 난감하면서 어렵죠? 미국의 MIT 대학교 미대어랩에서는 모럴머신(Moral Machine)이라는 웹 사이트를 만들어 이러한 윤리적 판단에 대한 사례를 수집하고 있습니다. 총 13가지의 딜레마 상황이 나오는데, 위의 사진에 있는 두 가지 사례를 보면서 여러분도 한번 판단해보세요. 모럴머신 웹사이트에는 다양한 사람들의 의견이 수집되고 있습니다. 하지만 그것으로 자율주행 자동차의 설계 윤리를 정할 수는 없습니다. 자율주행 자동차의 가장 윤리적인 선택은 사고가 발생할 때 피해를 최소화하는 것이겠지만 부득하게 누군가가 희생을 치러야 한다면 그 희생에 대한 책임을 자동차가 질 수 있을까요?

4. 책임성의 문제는 어떻게 해결해나갈까?

인공지능 책임성의 문제를 해결하기 위해서는 인공지능을 개발하는 사람, 공급하는 사람, 사용하는 사람 모두의 노력이 필요합니다.

인공지능을 개발하는 사람들은 책무성을 가져야 합니다. 책무성이란 ‘책임이나 의무를 지려는 태도’를 말합니다. 인공지능의 개발 과정부터 결과까지 품질을 인정하기 위해 노력하고 윤리적 절차를 충실히 따라야 합니다. 또, 개발자들 간 정보교류와 기술 갱신에 지속적으로 참여해야 합니다.

인공지능을 공급하는 사람들은 인공지능 기술의 보급 및 확산의 결과로 발생하는 사회적 폐해에 대한 책임을 공유해야 합니다. 또 오작동이나 사고에 따른 책임과 보상 원칙도 마련해야 합니다.

인공지능을 이용하는 사람들은 이용 결과에 따른 윤리 책임을 잘 숙지하고 안전 문제가 발생했을 때는 개발자, 공급자에게 책임을 물 수 있어야 합니다. 또, 이용 제품의 안내 지침을 잘 따라야 합니다.

Think Good AI

만약 인공지능 판사가 나와서 잘못된 판결을 내렸다고 가정해보자. 그에 대한 책임은 누구에게 있을까? 인공지능 스스로 학습하고 판단하여 결론을 내렸다면, 책임도 인공지능이 질 수 있을까? 만약 책임을 진다면 어떤 책임을 질 수 있을까?

5. 윤리적 인공지능 - 책임성 OX 퀴즈

책임성은 인공지능과 로봇이 내린 판단과 행동에 대해 누가 어떻게 책임을 질 것인가에 관한 것입니다.

Please select 2 correct answers

책임성은 인공지능과 로봇이 내린 판단과 행동에 대해 누가 어떻게 책임을 질 것인가에 관한 것입니다.

가천대 길병원은 국내 의료기관 중 최초로 IBM의 인공지능시스템 왓슨을 도입하였습니다. 도입 이후에 인간 의료진과 왓슨의 의견 일치율은 항상 일치합니다.

도입 이후에 인간 의료진과 왓슨의 의견 일치율은 점점 올라가고 있지만, 여전히 의료진의 처방과 왓슨의 처방이 다른 경우가 발생하고 있습니다.

모럴머신(Moral Machine)은 자율주행 자동차에서 발생하는 윤리적 딜레마에 관한 자료를 수집하는 사이트입니다.

모럴머신(Moral Machine)은 자율주행 자동차에서 발생하는 윤리적 딜레마에 관한 자료를 수집하는 사이트입니다.

<출처>

미래신호 탐지 기법으로 본 인공지능 윤리 이슈 – 글로벌 동향과 전망(2017, 한국정보화진흥원)

인공지능 윤리의 필요성과 국내외 동향(2017, 한국통신학회)

모럴머신 홈페이지 (www.moralmachine.net)

인천인공지능교육 표준안 및 가이드라인 연구(2020, 인천광역시교육청, 한국인공지능교육학회)